Exécutez Apache-Spark sur le notebook IPython

Contexte

Je m'intéresse au big data, à l'analyse en temps réel, à l'exploration de données, à l'apprentissage automatique et tout le monde écrit et parle de blogs de manière amusante. Ça semble intéressant. Donc, c'est juste que je suis personnellement intéressé et que je recherche. Je suis moins qu'un méchant, alors j'apprécie ce que je fais au niveau suivant.

- Identique au post précédent

Choses à faire

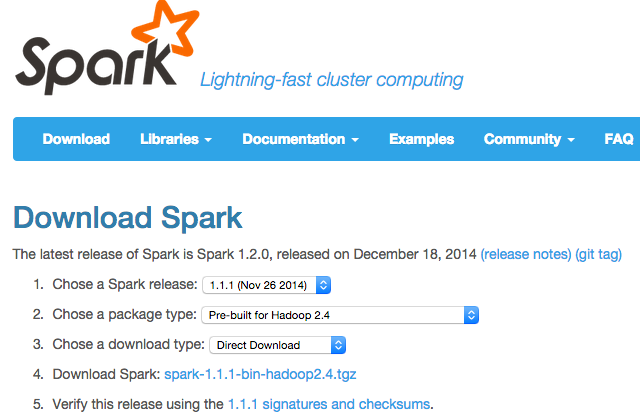

Tout ce que vous avez à faire est de configurer Apache-Spark pour le prêter à votre notebook IPython. Si vous le recherchez sur Google, diverses choses sortiront, mais je veux le garder près de moi, alors prenez note. Comme je l'ai appris plus tôt, spark 1.2.0 est sorti, il est donc déjà un peu vieux. Mais je pense que c'est la même chose de toute façon.

supposition

- Exécuter localement sur PC

- Le notebook IPython peut être démarré

environnement

- Windows 7 / Mac OS X Yosemite / Ubuntu 14.11

- Tous les 64 bits

procédure

- Téléchargez Spark et copiez-le ou installez-le quelque part

Lorsqu'il est installé avec Homebrew, il sera placé dans / usr / local / Cellar / apache-spark / 1.1.1.

-

Définissez la variable d'environnement sur

SPARK_HOMEexport SPARK_HOME="Dossier où Spark a été décompressé" -

Créez un profil IPython

$ ipython profile create pyspark -

Modifiez le profil d'environnement IPython

startup / 00-pyspark-setup.py#coding:utf-8 import os import sys os.environ['SPARK_HOME'] = '/usr/local/Cellar/apache-spark/1.1.1' spark_home = os.environ.get('SPARK_HOME', None) if not spark_home: raise ValueError('SPARK_HOME environment variable is not set') sys.path.insert(0, os.path.join(spark_home, 'libexec/python')) sys.path.insert(0, os.path.join(spark_home, 'libexec/python/lib/py4j-0.8.2.1-src.zip')) execfile(os.path.join(spark_home, 'libexec/python/pyspark/shell.py'))

Dans mon environnement, le fichier de configuration est dans ~ / .ipython / profile_pyspark. Réécrivons py4j-0.8.2.1-src.zip car cela dépend de la version.

Sous Windows, je pense que c'était autour du dossier utilisateur.

-

Essayez de commencer

$ ipython notebook --profile=pyspark -

On a l'impression que quelque chose bouge. Non!

référence

http://blog.cloudera.com/blog/2014/08/how-to-use-ipython-notebook-with-apache-spark/

Recommended Posts